Categoría: Inteligencia Artificial

-

AutoAgent: Un framework de código abierto para agentes LLM en lenguaje natural

AutoAgent es un proyecto de código abierto del Data Science and AI Laboratory de la Universidad de Hong Kong (HKU-DSAI Lab).Fue presentado en el artículo AutoAgent: A Fully-Automated and Zero-Code Framework for LLM Agents (arXiv:2502.05957) por Jiabin Tang, Tianyu Fan y Chao Huang. La plataforma permite crear y desplegar agentes de modelos de lenguaje (LLM)…

-

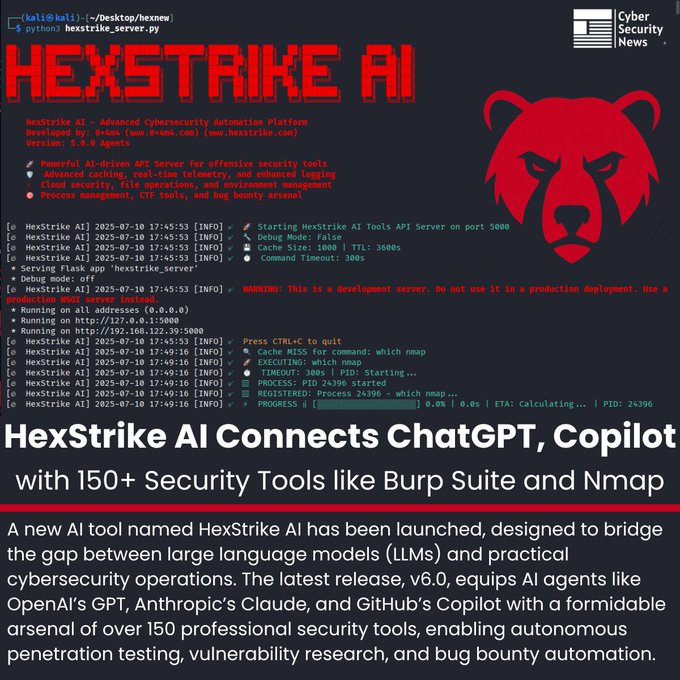

HexStrike AI v6.0: cuando la inteligencia artificial se conecta al corazón de la ciberseguridad 🔐🤖

La frontera entre lo humano y lo automatizado en ciberseguridad se vuelve cada vez más delgada. Con el lanzamiento de HexStrike AI v6.0, los modelos de lenguaje como ChatGPT, Claude o Copilot dejan de ser simples asistentes textuales para convertirse en auténticos operadores capaces de ejecutar pruebas de penetración de principio a fin. El secreto…

-

🤖 GPT-5: entre la promesa y la realidad

OpenAI lo presentó como su modelo más avanzado hasta la fecha . GPT-5 llegó envuelto en el brillo del marketing, acompañado de titulares que lo describen como un salto hacia la inteligencia artificial general (AGI). Pero cuando se apaga el eco de los anuncios y se pone a prueba en el mundo real, el panorama…

-

🧠Google Opal: crear aplicaciones con IA sin escribir código ya es posible

En un nuevo experimento que parece adelantar el rumbo de la computación creativa, Google presentó Opal, una herramienta que permite construir pequeñas aplicaciones impulsadas por inteligencia artificial usando solamente lenguaje natural. No es necesario saber programar. No se requiere instalar nada. Solo hay que escribir lo que uno quiere lograr, y el sistema se encarga…

-

Apple desafía las “rarezas” de la IA: ¿realmente razonan los grandes modelos lingüísticos? 🤖🧩

Días antes de su evento WWDC 2025, Apple dio un paso inusual: en lugar de presentar nuevas funciones, publicó un estudio titulado “The Illusion of Thinking”, cuestionando la capacidad de los llamados “modelos de razonamiento” (LRM) para pensar realmente en problemas complejos. Modelos de OpenAI, Anthropic—con Claude 3.7 Sonnet–, DeepSeek y Google Gemini fueron puestos…

-

🧠 Mistral lanza “Magistral”, la IA que razona paso a paso y plantea un desafío directo a OpenAI, Google y DeepSeek

La inteligencia artificial avanza rápido, pero no todas las propuestas siguen el mismo camino. Mientras empresas como OpenAI, Anthropic o DeepSeek compiten por crear modelos cada vez más potentes y cerrados, la startup francesa Mistral AI ha apostado por una dirección diferente: transparencia, razonamiento lógico y multilingüismo. Con el lanzamiento de Magistral, su nuevo modelo…

-

🚀 EdgeCortix lleva la IA generativa al borde con SAKURA-II y Raspberry Pi 5

EdgeCortix anunció que su acelerador de inteligencia artificial SAKURA-II (formato M.2) ya es compatible con una gama más amplia de plataformas basadas en arquitectura ARM, incluidas la Raspberry Pi 5 y la plataforma Rockchip RK3588 de Aetina. Esta ampliación de compatibilidad representa un paso importante hacia el acceso democratizado a capacidades avanzadas de IA generativa…

-

ByteDance lanza BAGEL‑7B‑MoT: un nuevo modelo de inteligencia artificial que ve, lee y crea

ByteDance (la empresa detrás de TikTok) presentó un nuevo modelo de inteligencia artificial llamado BAGEL‑7B‑MoT, y aunque suena complejo, su propósito es muy claro: combinar texto, imágenes y video en un solo sistema inteligente, que pueda entender y generar contenido como si estuviera “viendo” y “pensando”. ¿Qué es BAGEL? BAGEL es un modelo de IA…

-

DeepSeek R1-0528: la inteligencia artificial china que no quiere quedarse atrás

Mientras la competencia por la supremacía en inteligencia artificial se libra entre gigantes como OpenAI, Google y Anthropic, desde China, la startup DeepSeek avanza con paso firme y silencioso. Su última jugada: la actualización de su modelo insignia, el DeepSeek R1-0528, una versión que demuestra que en el terreno de la IA, ya no hay…

-

Claude 4: la nueva inteligencia artificial que viene a competir fuerte

El mundo de la inteligencia artificial sigue avanzando a pasos agigantados, y ahora es el turno de Claude 4, la nueva familia de modelos presentada por Anthropic, una empresa que viene ganando terreno en este campo. Con esta nueva generación, se meten de lleno en la competencia con gigantes como OpenAI (ChatGPT) y Google (Gemini).¿Vale…