Kategorie: Künstliche Intelligenz

-

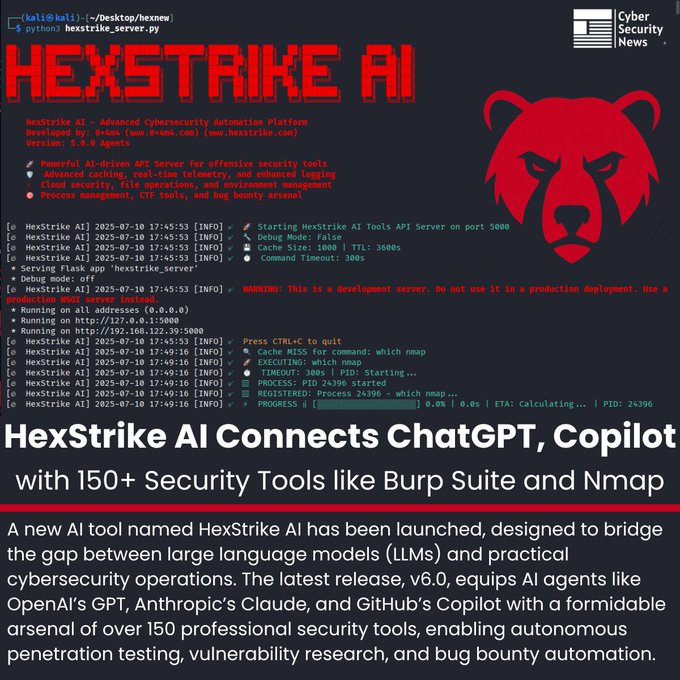

HexStrike AI v6.0: wenn künstliche Intelligenz das Herz der Cybersicherheit erreicht 🔐🤖

Die Grenze zwischen menschlicher und automatisierter Cybersicherheit wird immer schmaler. Mit der Veröffentlichung von HexStrike AI v6.0 werden Sprachmodelle wie ChatGPT, Claude oder Copilot nicht mehr nur als textbasierte Assistenten verstanden, sondern als echte Operatoren, die vollständige Penetrationstests von Anfang bis Ende durchführen können. Das Geheimnis liegt in seiner Architektur: HexStrike arbeitet als MCP-Server (Model…

-

🤖 GPT-5: Zwischen Versprechen und Realität

OpenAI stellte GPT-5 als sein bisher fortschrittlichstes Modell vor . Umgeben vom Glanz des Marketings und begleitet von Schlagzeilen, die es als großen Schritt hin zur allgemeinen künstlichen Intelligenz (AGI) feiern, sorgte der Launch für viel Aufmerksamkeit. Doch sobald der Lärm der Ankündigungen verklungen ist und das Modell im Alltag getestet wird, zeigt sich ein…

-

🧠 Google Opal: KI-gestützte Apps erstellen – ganz ohne Programmierkenntnisse

Mit einem neuen Experiment, das die Zukunft der kreativen Informatik vorwegnimmt, hat Google Opal vorgestellt – ein Tool, mit dem sich kleine, KI-basierte Anwendungen allein mit natürlicher Sprache erstellen lassen. Keine Programmierkenntnisse notwendig. Keine Installation. Man beschreibt einfach, was man erreichen möchte – den Rest übernimmt das System. Opal ist derzeit als öffentliche Beta (nur…

-

🧠 Mistral stellt „Magistral“ vor – die KI, die Schritt für Schritt denkt und OpenAI, Google sowie DeepSeek herausfordert

Künstliche Intelligenz entwickelt sich rasant, doch nicht alle Ansätze verlaufen gleich. Während Unternehmen wie OpenAI, Anthropic oder DeepSeek sich auf immer mächtigere, geschlossene Modelle konzentrieren, verfolgt das französische Startup Mistral AI einen anderen Weg: Transparenz, logisches Denken und native Mehrsprachigkeit. Mit der Veröffentlichung von Magistral, seiner neuen KI-Modellfamilie, liefert Mistral nicht nur Antworten, sondern legt…

-

Apple hinterfragt KI-Muster: Können Sprachmodelle wirklich denken? 🤖🧩

Wenige Tage vor der WWDC 2025 überraschte Apple mit einer ungewöhnlichen Veröffentlichung: Statt neuer Features präsentierte das Unternehmen die Studie „The Illusion of Thinking“, die bezweifelt, ob sogenannte „Reasoning Models“ (LRM) komplexe Probleme tatsächlich durchdenken. Modelle von OpenAI, Anthropic (Claude 3.7 Sonnet), DeepSeek und Google Gemini wurden auf klassische Logikrätsel getestet – wie die Türme…

-

🚀 EdgeCortix bringt generative KI an den Rand mit SAKURA-II und Raspberry Pi 5

EdgeCortix hat bekannt gegeben, dass sein KI-Beschleuniger SAKURA-II (im M.2-Format) nun mit einer breiteren Palette von ARM-basierten Plattformen kompatibel ist – darunter der Raspberry Pi 5 sowie die Rockchip RK3588-Plattform von Aetina. Diese Erweiterung stellt einen wichtigen Schritt dar, um fortschrittliche generative KI-Funktionen am Edge zugänglich, effizient und flexibel einsetzbar zu machen. Der große Vorteil…

-

ByteDance veröffentlicht BAGEL‑7B‑MoT: ein neues KI‑Modell, das sieht, liest und erschafft

ByteDance (das Unternehmen hinter TikTok) hat ein neues Modell der künstlichen Intelligenz vorgestellt: BAGEL‑7B‑MoT. Auch wenn der Name kompliziert klingt, ist das Ziel ganz einfach: Text, Bilder und Videos in einem einzigen intelligenten System zu vereinen, das Inhalte verstehen und erzeugen kann – als würde es „sehen“ und „denken“. Was ist BAGEL? BAGEL ist ein…

-

DeepSeek R1-0528: Die chinesische KI, die nicht zurückbleiben will

Während sich der Kampf um die Vorherrschaft in der Künstlichen Intelligenz zwischen Giganten wie OpenAI, Google und Anthropic abspielt, bewegt sich das chinesische Start-up DeepSeek leise, aber entschlossen vorwärts. Der neueste Schritt: ein Update seines Flaggschiff-Modells, DeepSeek R1-0528 – eine Version, die zeigt, dass es in der KI-Welt keine kleinen Mitspieler mehr gibt. R1-0528 ist…

-

Claude 4: Die neue KI, die kräftig mitmischt

Die Welt der künstlichen Intelligenz entwickelt sich rasant weiter – und jetzt ist Claude 4 an der Reihe, die neue Modellreihe von Anthropic, einem Unternehmen, das sich schnell einen Namen macht. Mit dieser Generation steigt es direkt in den Wettbewerb mit Größen wie OpenAI (ChatGPT) und Google (Gemini) ein.Lohnt es sich, hinzuschauen? Auf jeden Fall…

-

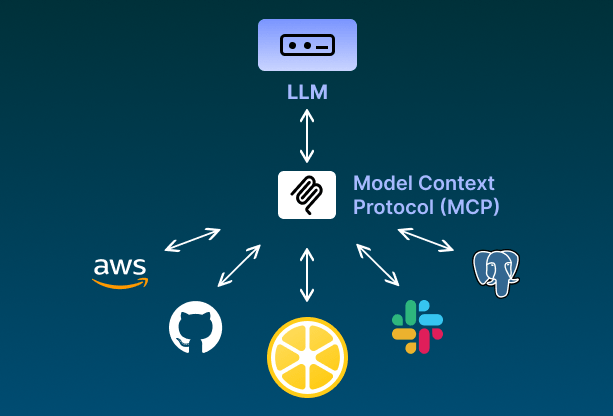

⚙️ Die Integration von LLM-Agenten mit DevOps-Tools ist keine Science-Fiction mehr.

MCP-Server (Model Context Protocol) ermöglichen es Sprachagenten, direkt mit wichtigen Tools für Infrastruktur, Automatisierung und Monitoring zu interagieren.Das schafft intelligentere Workflows, bei denen die KI nicht nur Vorschläge macht… sondern auch handelt. 💡 Hier sind einige MCP-Server, die du bereits heute nutzen kannst:🔷 AWS MCP: steuere Amazon Web Services über einen Agenten → https://github.com/awslabs/mcp 💬…