Catégorie : Intelligence Artificielle

-

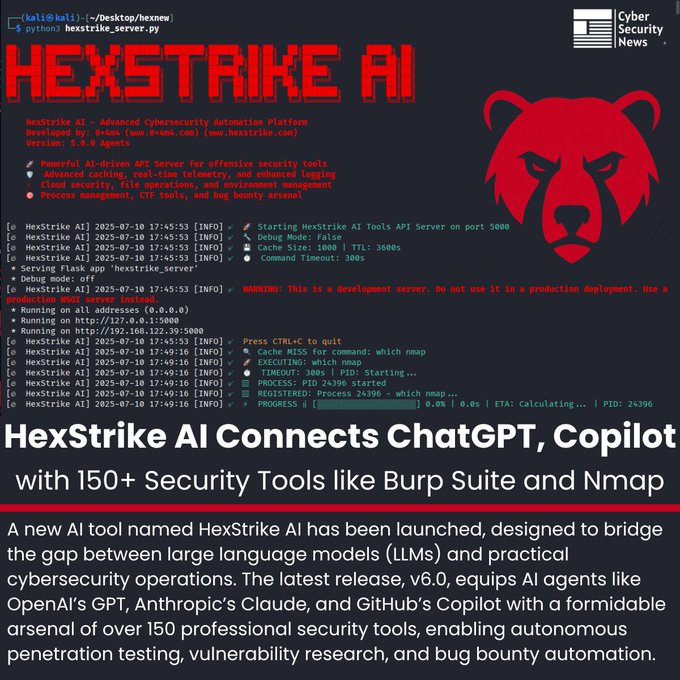

HexStrike AI v6.0 : quand l’intelligence artificielle se connecte au cœur de la cybersécurité 🔐🤖

La frontière entre l’humain et l’automatisé en cybersécurité devient de plus en plus mince. Avec le lancement de HexStrike AI v6.0, les modèles de langage comme ChatGPT, Claude ou Copilot cessent d’être de simples assistants textuels pour devenir de véritables opérateurs capables d’exécuter des tests de pénétration de bout en bout. Le secret réside dans…

-

🤖 GPT-5 : entre la promesse et la réalité

OpenAI a présenté GPT-5 comme son modèle le plus avancé à ce jour. GPT-5 est arrivé auréolé de marketing, accompagné de titres le décrivant comme un grand pas vers l’intelligence artificielle générale (AGI). Mais lorsque l’écho des annonces s’estompe et que l’on teste le produit dans le monde réel, le tableau est moins épique :…

-

🧠 Google Opal : créer des applications avec l’IA sans écrire une seule ligne de code, c’est désormais possible

Dans une nouvelle expérimentation qui semble anticiper l’avenir de l’informatique créative, Google a lancé Opal, un outil qui permet de créer de petites applications alimentées par l’intelligence artificielle en utilisant uniquement du langage naturel. Aucun besoin de savoir coder. Rien à installer. Il suffit de décrire ce que vous voulez faire, et le système s’en…

-

🧠 Mistral lance « Magistral », l’IA qui raisonne pas à pas — un défi ouvert à OpenAI, Google et DeepSeek

L’intelligence artificielle progresse à grande vitesse, mais toutes les approches ne sont pas identiques. Alors que des sociétés comme OpenAI, Anthropic ou DeepSeek rivalisent avec des modèles toujours plus performants et fermés, la startup française Mistral AI choisit une voie différente : transparence, raisonnement logique et multilinguisme natif. Avec le lancement de Magistral, sa nouvelle famille…

-

Apple défie les bizarreries de l’IA : les grands modèles linguistiques raisonnent-ils vraiment ? 🤖🧩

Quelques jours avant la WWDC 2025, Apple a pris une initiative inhabituelle : au lieu d’annoncer de nouvelles fonctions, la firme a publié une étude intitulée “The Illusion of Thinking”, qui remet en question la capacité des « modèles de raisonnement » (LRM) à réellement penser face à des problèmes complexes. Des modèles d’OpenAI, Anthropic (Claude 3.7…

-

🚀 EdgeCortix amène l’IA générative en périphérie avec SAKURA-II et Raspberry Pi 5

EdgeCortix a annoncé que son accélérateur d’intelligence artificielle SAKURA-II (format M.2) est désormais compatible avec un plus large éventail de plateformes basées sur l’architecture ARM, y compris le Raspberry Pi 5 et la plateforme Rockchip RK3588 d’Aetina. Cette extension de compatibilité représente une avancée majeure vers un accès démocratisé aux capacités d’IA générative avancées en…

-

ByteDance lance BAGEL‑7B‑MoT : un nouveau modèle d’IA qui voit, lit et crée

ByteDance (l’entreprise derrière TikTok) a présenté un nouveau modèle d’intelligence artificielle appelé BAGEL‑7B‑MoT. Même si son nom semble compliqué, son objectif est simple : combiner texte, images et vidéo dans un seul système intelligent capable de comprendre et de générer du contenu comme s’il “voyait” et “réfléchissait”. Qu’est-ce que BAGEL ? BAGEL est un modèle…

-

DeepSeek R1-0528 : l’intelligence artificielle chinoise qui refuse de rester en arrière

Alors que la course à la suprématie en intelligence artificielle oppose des géants comme OpenAI, Google et Anthropic, une startup chinoise avance à pas sûrs et discrets : DeepSeek. Sa dernière initiative ? Une mise à jour de son modèle phare, le DeepSeek R1-0528, une version qui montre que, dans le domaine de l’IA, il…

-

Claude 4 : la nouvelle intelligence artificielle qui vient concurrencer sérieusement

Le monde de l’intelligence artificielle avance à toute vitesse, et c’est maintenant au tour de Claude 4, la nouvelle famille de modèles créée par Anthropic, une entreprise qui gagne du terrain dans ce domaine. Avec cette nouvelle génération, elle entre en compétition directe avec des géants comme OpenAI (ChatGPT) et Google (Gemini).Faut-il y prêter attention…

-

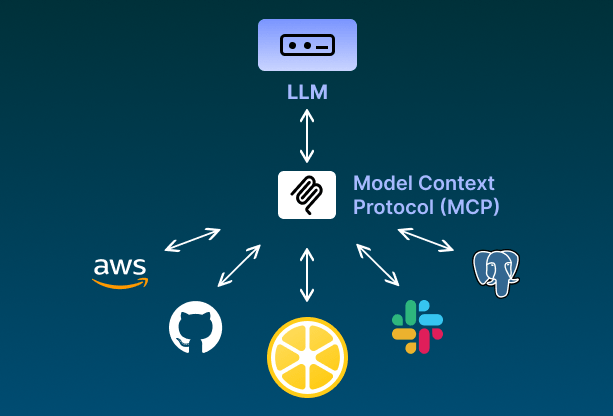

⚙️ L’intégration entre les agents LLM et les outils DevOps n’est plus de la science-fiction.

Les serveurs MCP (Model Context Protocol) permettent aux agents en langage naturel d’interagir directement avec les outils clés d’infrastructure, d’automatisation et de surveillance.Cela ouvre la voie à des workflows plus intelligents, où l’IA ne fait pas que suggérer… elle agit. 💡 Voici quelques serveurs MCP que vous pouvez utiliser dès aujourd’hui : 🔷 AWS MCP…